原文链接: https://openai.com/index/introducing-simpleqa/

OpenAI开源了最新基准测试集SimpleQA,可以帮助开发者轻松检测、校准大模型的真实性能力。

目前,很多大模型会出现一本正经胡说八道的问题,例如,你提问NBA历史上得分最多的是谁,它回答是迈克尔乔丹,实际上是勒布朗詹姆斯。包括OpenAI自己发布的GPT-4o、o1-preview、o1mini等前沿模型都有这些“幻觉”难题。

所以,SimpleQA对于开发者来说,可以精准测试大模型能否输出正确的答案,并对模型的说谎能力进行校准然后进行大幅度优化完善模型能力。

SimpleQA简单介绍

在数据收集阶段,SimpleQA的问题参考答案由两名独立的 AI 训练员确定,并且训练员在创建问题时被要求提供支持答案的网页链接,以确保答案有可靠的依据。

例如,对于 “谁是苹果公司的创始人之一” 这样常识性问题,训练员会根据历史资料和官方信息确定答案为 史蒂夫乔布斯等,并附上如苹果公司官方网站等相关链接作为证据。

同时,问题的设计使得预测答案易于评估,只允许有一个明确且无可争议的答案,避免了模糊性和歧义性。比如 “哪一年 iPhone 首次发布”,答案明确为“2007年”,而不是一个范围或模糊的表述。

SimpleQA的评估问题和答案都非常简短,这使得运行速度快且操作简单。在评估模型回答时,通过 OpenAI API进行评分也十分迅速。数据集中包含4326个问题,能够在一定程度上降低不同次运行之间的方差,使评估结果更加稳定可靠。

例如,在对多个模型进行测试时,不会因为数据集本身的不稳定性而导致结果出现较大波动,从而能够更准确地比较模型之间的性能差异。

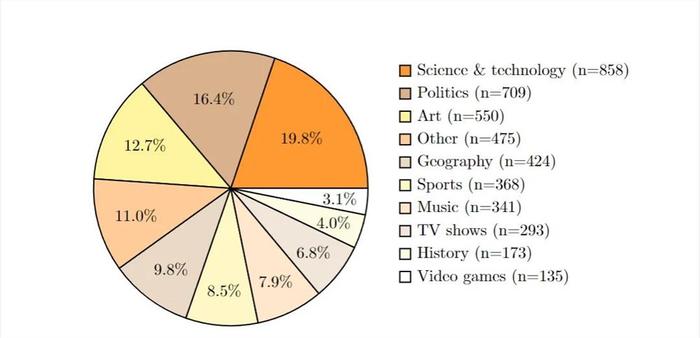

SimpleQA的评估集非常多元化。涵盖历史、科学技术、艺术、地理、电视节目等多个领域。这种多样性使得评估结果更具普遍性和代表性,能够全面地检验模型在不同知识领域的事实性回答能力。

另一个好处是它的校准测量功能。通过询问模型对其答案的信心,研究者可以了解模型是否知道它们知道什么,这是一个很重要的校准现象。如果一个模型能够准确地评估自己的信心水平,那么它就是一个校准良好的模型。

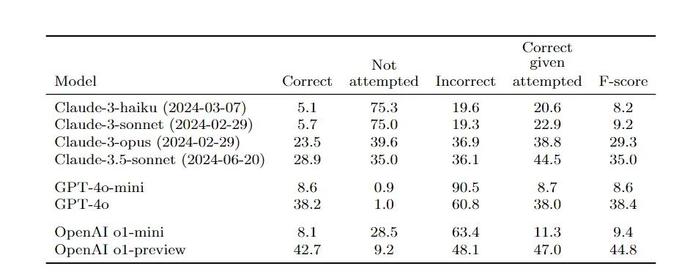

OpenAI通过SimpleQA对GPT-4o、o1-preview、o1mini、Claude-3-haiku、Claude-3-sonnet等前沿模型进行了综合测试。结果显示,较大模型通常具有更高的性能,但即使是前沿模型在SimpleQA 上的表现也并非完美。

例如,GPT -4o 在回答一些问题时能够给出较高比例的正确答案,但仍有部分错误回答和未尝试回答的情况。同时,通过测量模型的校准情况,发现模型虽然有一定的信心概念,但普遍存在高估自己信心的问题,模型的信心水平与实际回答的准确性之间存在差距。

SimpleQA 是什么

SimpleQA 是 OpenAI 推出的基准测试,用在评估大型语言模型回答简短、寻求事实问题的能力。SimpleQA 包含 4326 个问题,每个问题设计为只有一个正确答案,易于评分。

SimpleQA 挑战性强,即使是最先进的大模型如 o1-preview 和 Claude Sonnet 3.5 的准确率也不到 50%。所有问题经过两位独立标注员验证,确保参考答案的准确性和时效性。

SimpleQA 能评估模型的事实性回答能力,能测量模型的“校准”程度,即模型对自己回答准确性的自我评估能力。SimpleQA 的数据集具有多样性,涵盖多个主题,包括历史、科学、艺术等,用在推动更可靠、可信赖的语言模型的发展。

SimpleQA 的主要功能

- 评估事实性回答能力: SimpleQA 主要用在测试语言模型回答简短、事实性问题的能力,问题设计为只有一个正确答案。

- 挑战性问题设计: 问题对抗性地收集,针对 GPT-4 等前沿模型,确保测试具有挑战性。

- 易于评分: 问题设计让答案易于评定,答案被分类为正确、错误或未尝试。

- 模型自我认知评估: 基于评估模型是否“知道自己知道什么”,衡量模型的自我认知能力。

- 校准测量: 测量模型对回答准确性的自信程度,即模型是否能准确评估自己的回答。

SimpleQA 的技术原理

- 数据收集与验证: 基于 AI 训练师创建问题和答案对,由另一名 AI 训练师独立验证答案,确保一致性。

- 高标准问题筛选: 问题必须满足特定标准,包括单一答案、答案随时间不变、有证据支持、具有挑战性,且截至 2023 年可回答。

- 质量控制: 用 ChatGPT 分类器检测违反标准的问题是提高问题质量的步骤之一。

- 多样性和覆盖: 基于 ChatGPT 分类问题主题和答案类型,确保数据集的多样性。

- 评分机制: 用提示的 ChatGPT 分类器对模型的回答进行评分,确定其是否正确、错误或未尝试。

- 性能评估: 比较模型在 SimpleQA 上的表现,评估其在事实性问题回答方面的能力。

- 校准评估: 询问模型对答案的置信度,且与实际准确性进行比较,评估模型的校准能力。

评论区